ぬくぬくの、PC環境にAI環境を構築すべく、Ollama×gpt-oss-20bの環境を構築してみました。

ぬくぬくのPCスペック

| CPU | Intel(R) Core(TM) i7-14700F (2.10 GHz) |

| RAM | 64.0 GB |

| OS | Windows 11 Pro (64 ビット) |

| GPU | NVIDIA Geforce RTX 4060 Ti (16GB) |

| ビデオメモリ | 16GB |

Ollama×gpt-oss-20bセットアップ手順

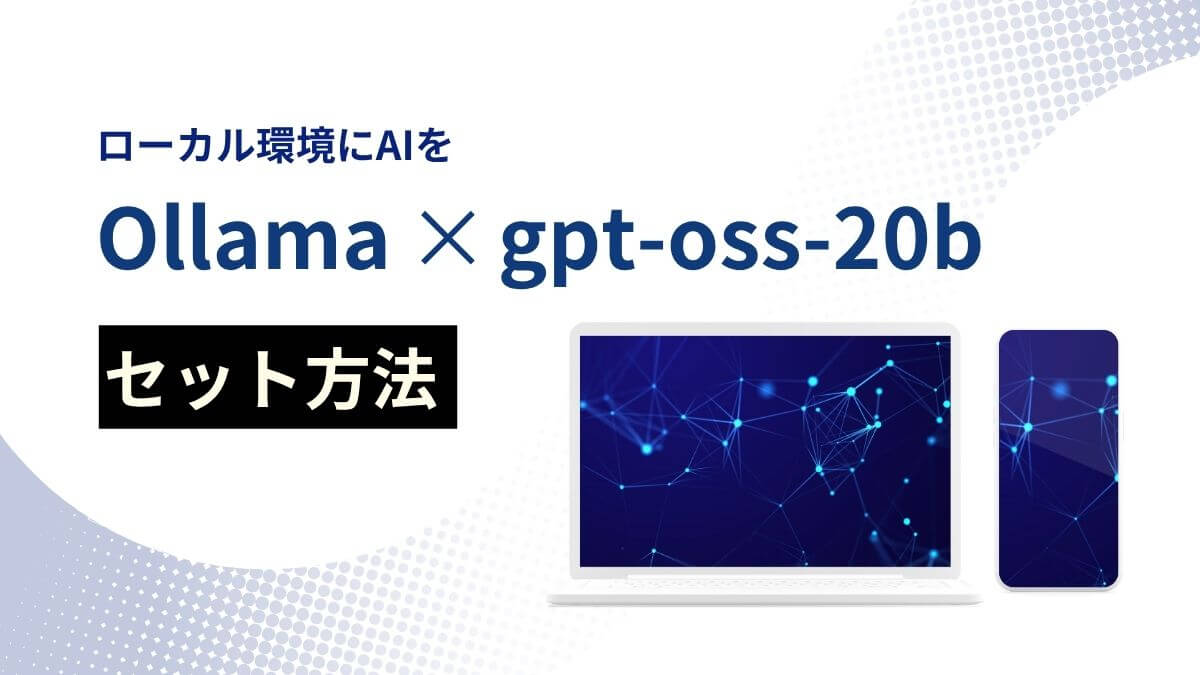

ステップ①:Ollama公式へアクセス

Ollama公式へアクセスします。

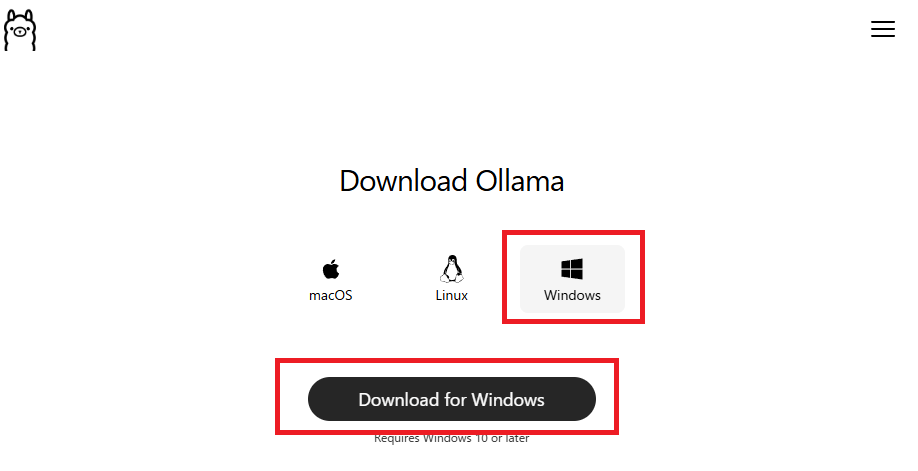

ステップ②:ダウンロードした「OllamaSetup.exe」を実行

「Install」ボタンをクリック。

なお、インストールドライブは選択できません。

【Ollamaのインストール先フォルダ】

C:\Users\[ユーザー名]\AppData\Local\Programs\Ollama

インストールが完了するまでしばらく待ちます。

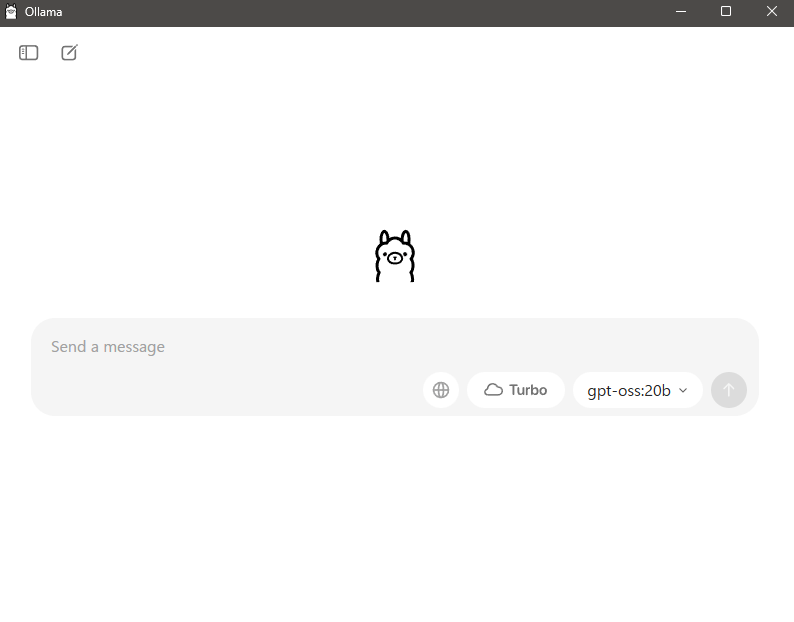

ステップ③:Ollamaの画面が表示される

インストールが終わるとOllamaの画面が表示されます。

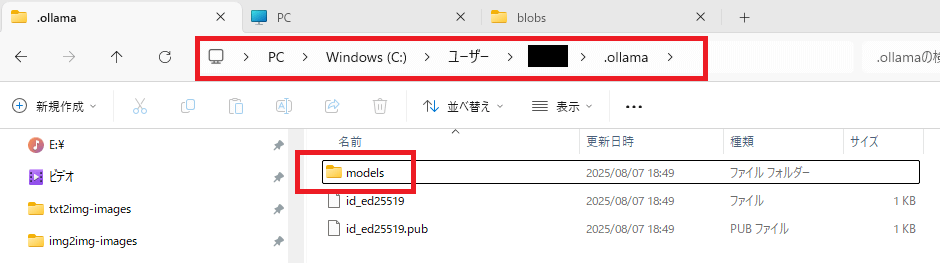

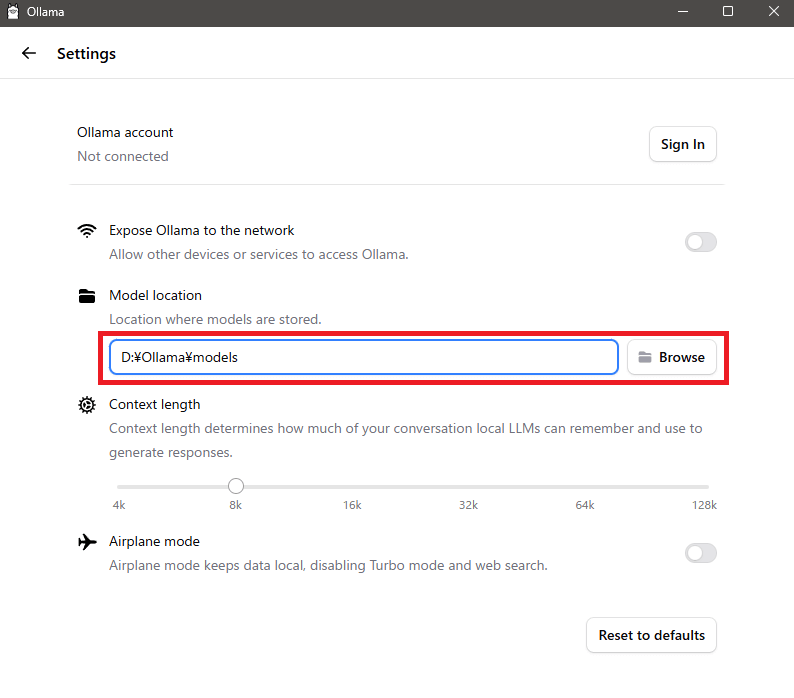

ステップ④:「gpt-oss:20b」ダウンロードフォルダを変更

Ollamaのデフォルトのモデルフォルダは

「C:¥Users\[ユーザー名]\.Ollama\models」フォルダ

になっています。

これを変更しておきましょう。(不都合なければそのままでもOK)

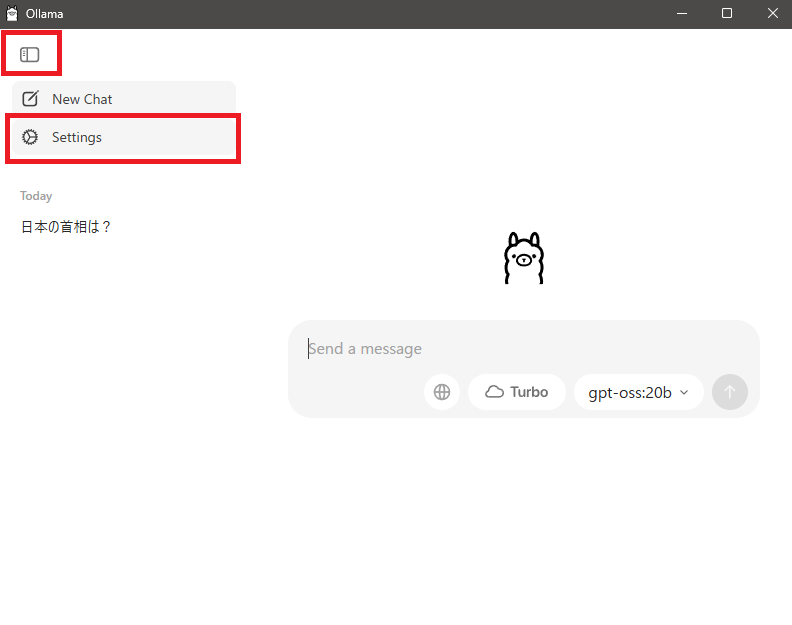

左上のアイコンをクリックして「settings」をクリック。

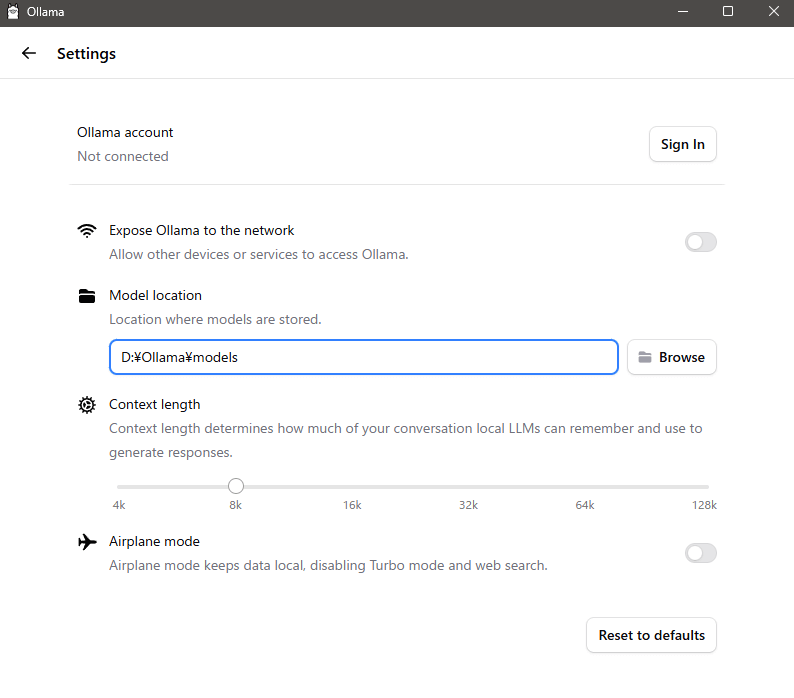

設定画面が開きます。

「Model location」を任意のフォルダに変更します。(設定は自動反映されます)

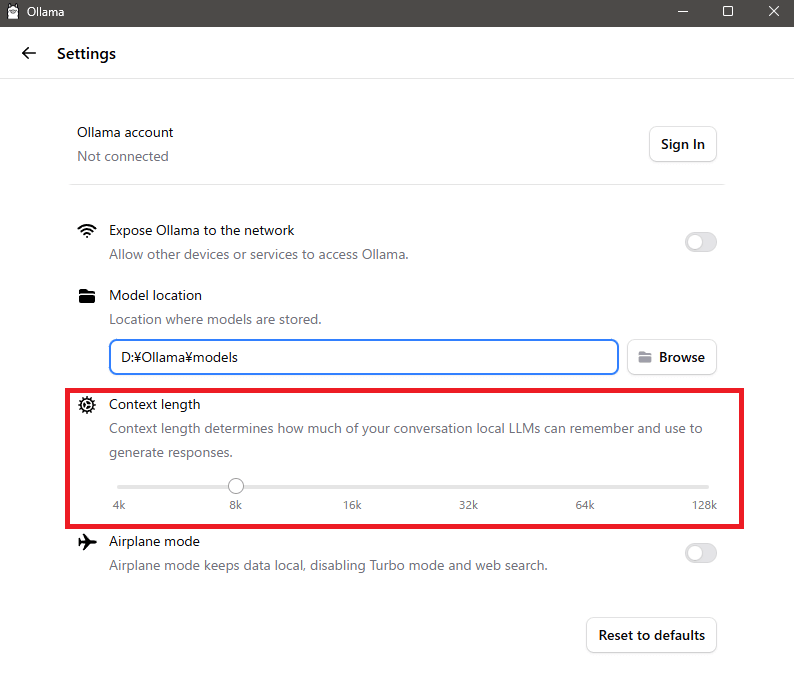

ついでに「Context length」を変更します。

ぬくぬくの環境では「32k」にしています。

ステップ⑤:質問を投げてgpt-oss:20bをダウンロード

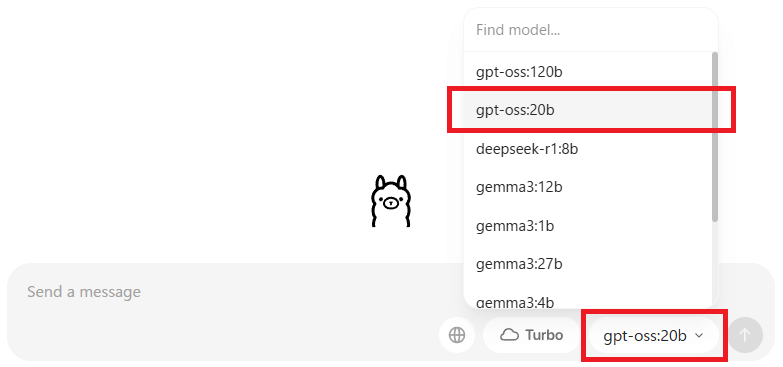

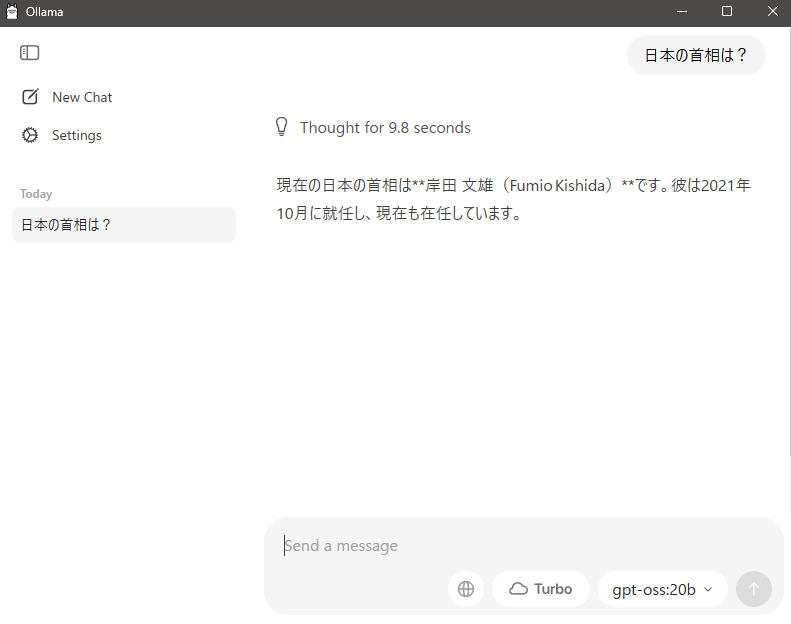

チャット欄右下に、モデルを選択できるリストボックスがあるので、「gpt-oss:20b」を選択します。

【Ollamaで使えるモデル】

- gpt-oss:120b

- gpt-oss:20b

- deepdeek-r1:8b

- gemma3:12b

- gemma3:1b

- gemma3:27b

- gemma3:4b

- qwen3:30b

- qwen3:4b

- qwen3:8b

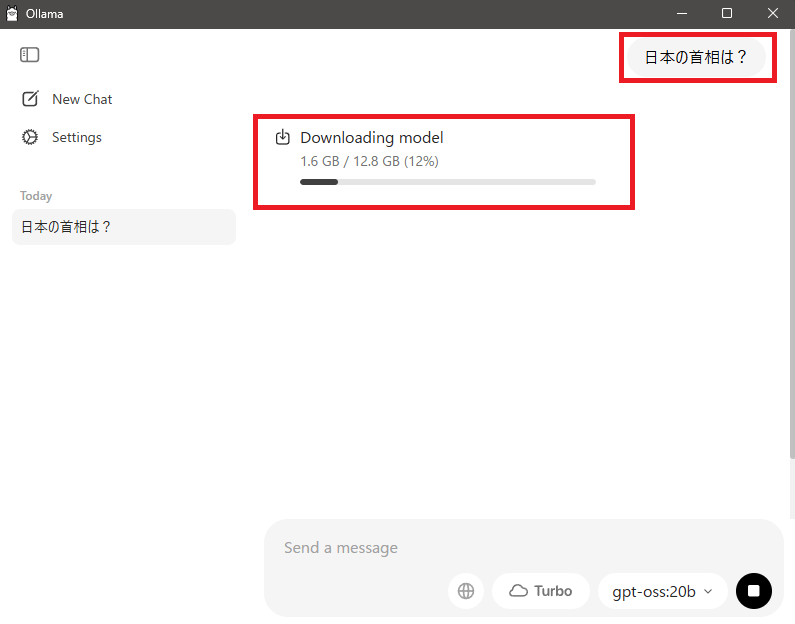

チャット欄に何か投げると、ダウンロードが始まります。

ダウンロードが終わると、質問に答えてくれます。

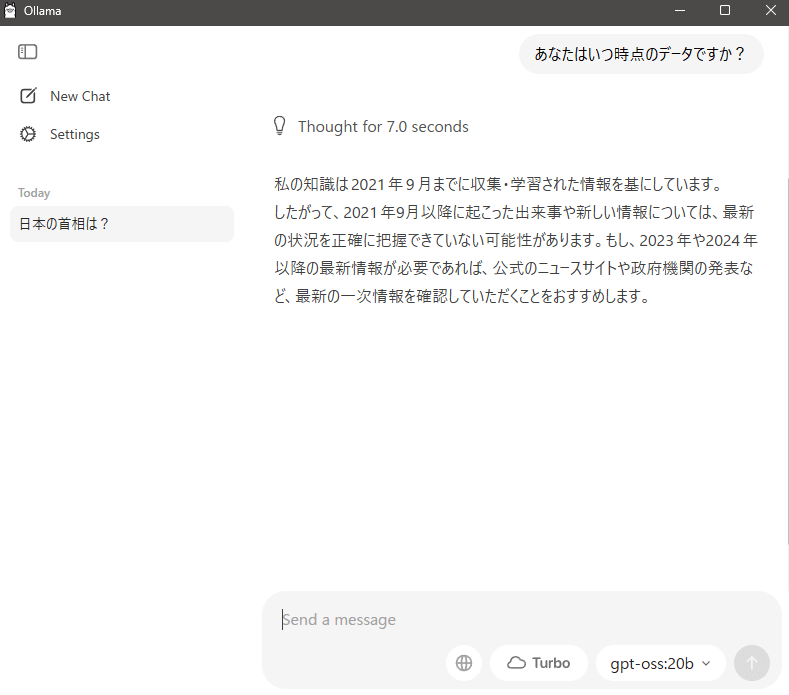

gpt-oss:20bはいつ時点のデータか聞いてみて、帰ってくるまで約7秒。真偽はともかく、速度的な意味では許容範囲ではないでしょうか。

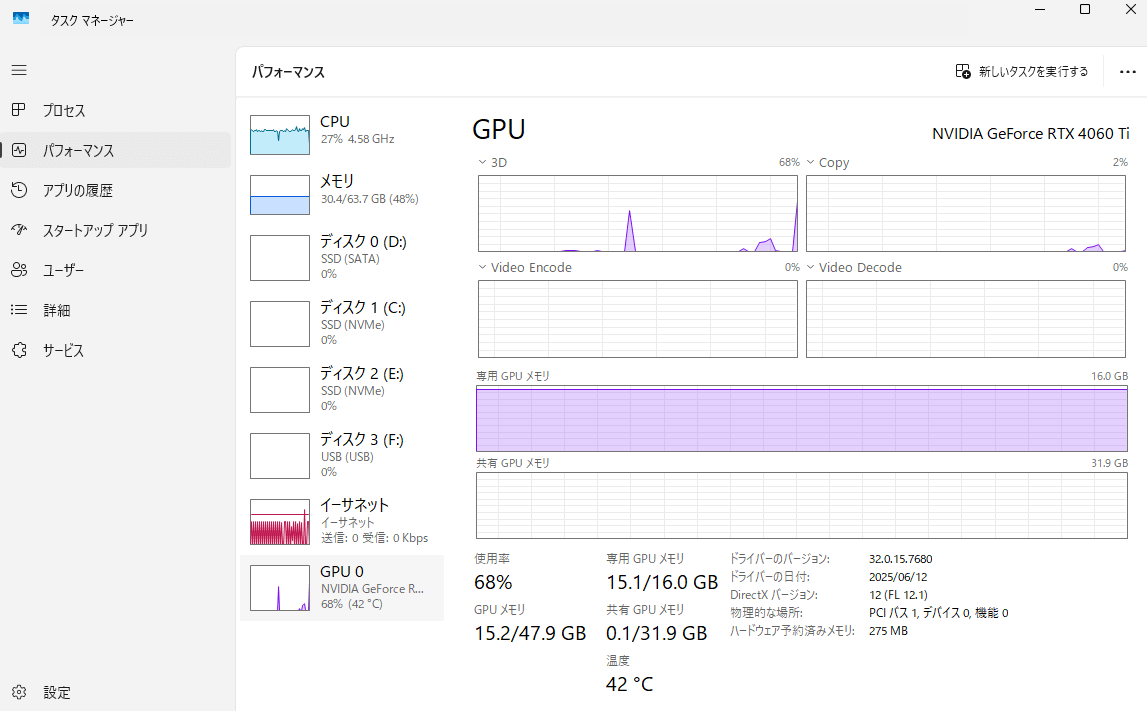

Ollama×gpt-oss-20bで消費するリソース

ぬくぬくのローカルPCでは、

CPU:30%

メモリ:30GB

GPU:16GB(MAX張り付き)

という感じでした。

ぬくぬくのCPUは、Intel(R) Core(TM) i7-14700F (2.10 GHz)で、今は改善されたとはいえトラブルがあったCPUなので、GPU優先で消費してくれるのは助かります。

以上、ご参考まで。